PÅ FARTEN? LYTT ELLER SE

Oppsummering

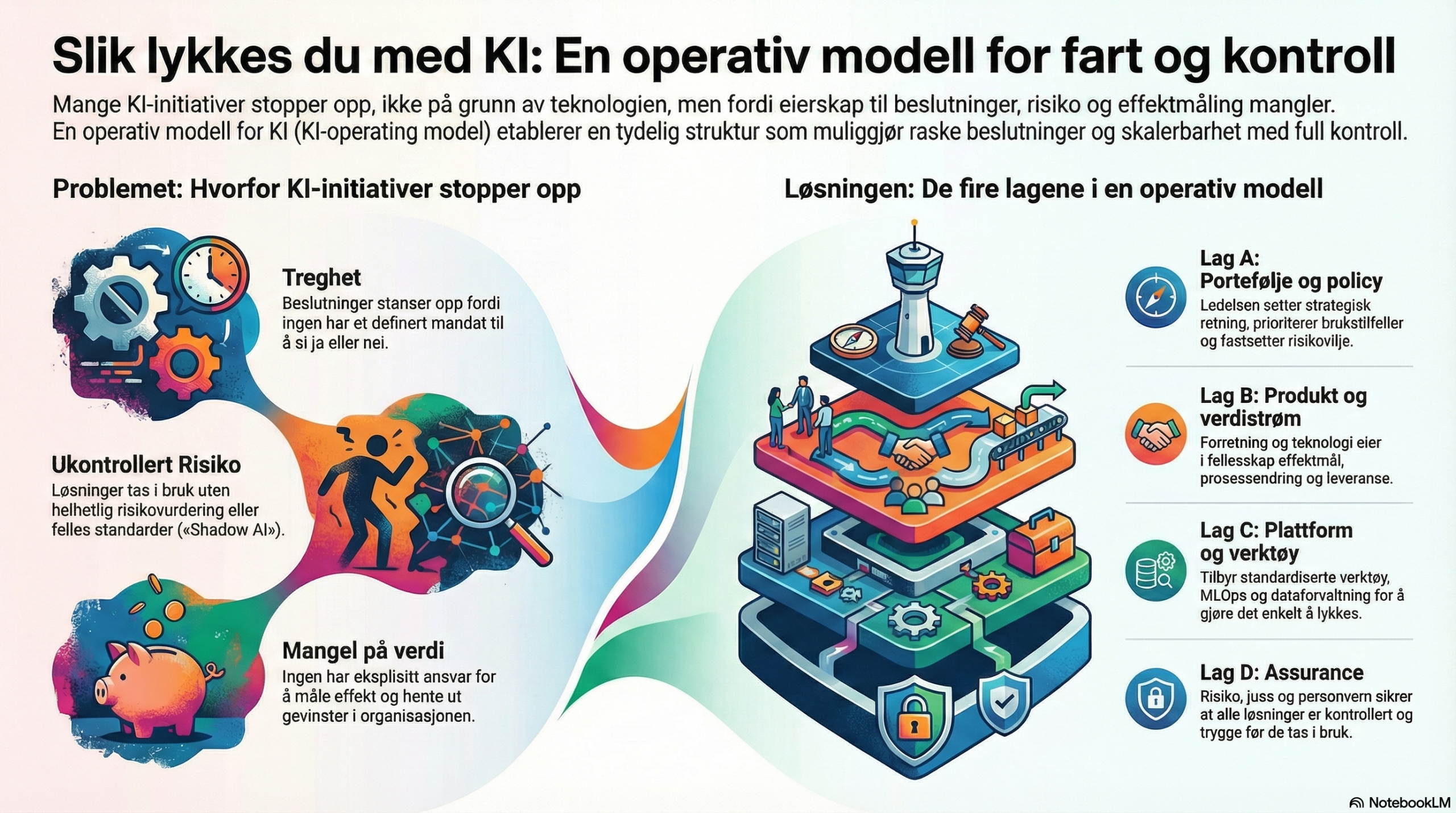

Mange KI-initiativ stopper ikke på grunn av teknologi, men fordi ingen eier helheten: hvem som bestemmer, hvem som har ansvar for data og risiko, og hvem som faktisk måler effekt i drift. En tydelig KI-operating model gjør at dere kan ta raske beslutninger uten å miste kontroll.

1. Hvorfor operating model er flaskehalsen i KI

Når en pilot “funker”, oppstår det et nytt spørsmål som teknologien ikke svarer på: Hvem tar beslutningen om å gjøre dette til en varig løsning – og på hvilket grunnlag? Uten en operating model får dere typisk:• Treghet: Alle må “spørre alle” fordi beslutningsrett ikke er definert. • Risiko-glidning: Løsninger går i bruk uten at noen eier helhetlig risikovurdering. • Måleblindhet: Ingen har eksplisitt ansvar for effektmål og gevinstrealisering i linjen. • “Shadow AI”: Bruk skjer i praksis, men uten felles standarder og sporbarhet.

Dette er grunnen til at modne organisasjoner behandler KI som en styrt portefølje og verdistrøm, ikke som enkeltstående eksperimenter.

2. Hva er en KI-operating model – egentlig?

En KI-operating model er den praktiske “oppskriften” på hvordan dere styrer, bygger, tar i bruk og forbedrer KI på tvers av virksomheten. Den består av fire ting:1) Roller og ansvar (én eier per beslutning og per KI-system) 2) Beslutningsflyt (hva avgjøres hvor – og med hvilke kriterier) 3) Leveransemodell (produkt/verdistrøm + plattformstøtte) 4) Kontrollspor (dokumentasjon, test/monitorering, hendelser, endringer)

Dette kan også forstås som et “ledelsessystem” for KI: ISO beskriver ISO/IEC 42001 som et AI management system som etablerer policyer, mål og prosesser for ansvarlig utvikling/bruk av KI.[1] NIST AI RMF gir i tillegg en praktisk struktur med fire funksjoner (Govern, Map, Measure, Manage) som mange bruker som ryggrad i styring og risikohåndtering.[2]

3. Den enkle modellen: fire lag som må sitte

Hvis dere vil ha noe som fungerer i praksis (og skalerer), organiser KI-operating model i fire lag:Lag A: Portefølje og policy (leder/ledergruppe) Setter retning, prioriterer brukstilfeller, bestemmer risikovilje og standarder (inkl. “hva er lov internt”). DFØ er tydelig på at virksomhetsledelsen har overordnet ansvar i gevinstrealisering, men bør delegere praktisk gjennomføring til definerte roller.[6]

Lag B: Produkt/verdistrøm (forretning + tech sammen) Eier effektmål, prosessendring, og “definition of done” i drift. Her må prosesseier og produkteier være reelle eiere – ikke bare “bestillere”.

Lag C: Plattform og enablement (data/ML-plattform, sikkerhet, arkitektur) Gjør det lett å gjøre riktig: standard verktøy, MLOps, dataforvaltning, tilgangsstyring, logging, monitorering.

Lag D: Assurance (risiko/juss/personvern/kvalitet) Sikrer at det som slippes i drift faktisk er kontrollert. For personopplysninger betyr dette ofte at DPIA må vurderes og gjennomføres der det er påkrevd.[8] For høyrisiko KI hos “providers” krever AI Act et dokumentert kvalitetssystem som dekker bl.a. design, utvikling, testing, risikohåndtering og håndtering av endringer/ettermarked.[3]

4. Rollebibliotek: hvem eier hva?

Hold dette konkret. Et minimum som fungerer i 50+ organisasjoner:• KI-eier (executive sponsor): eier policy, risikovilje, finansiering og prioriteringslogikk. • Porteføljeansvarlig: eier pipeline, prioritering, stopp/start-beslutninger og kapasitetsbalanse. • Produkteier / verdistrømsleder: eier verdihypotese, krav og leveranseplan i drift. • Prosesseier (linje): eier prosessendring, adopsjon, opplæring og gevinstuttak. • Dataeier / dataforvalter: eier datakvalitet, tilgang, definisjoner, datakontrakter og formål. • Modeleier (teknisk): eier modellvalg, evaluering, monitorering, drift/tilbakerulling. • Risiko- og compliance-eier: eier risikovurdering, kontroller, revisjonsspor og hendelser. • Personvernombud / privacy lead: gir metodikk og kvalitetssikrer personvernspor (DPIA m.m.).[8] • Sikkerhetsansvarlig: eier trusselmodell, sikkerhetskrav og tilgangsstyring.

Det viktigste prinsippet: Én rolle har “ja/nei”-rett per beslutning – andre er rådgivende (ikke vetorett i praksis, med mindre dere eksplisitt bestemmer det).

5. Seks beslutninger som må ha tydelig “eier”

Hvis disse seks ikke har navngitte eiere, går dere sakte:1) Prioritering: hvilke use-caser får tid/penger nå? 2) Data-tilgang: hvilke datasett kan brukes til hvilket formål – og på hvilke vilkår? 3) Risiko-klasse: hva er “light” vs “høyrisiko”, og hvilke kontrollkrav utløses? 4) Go-live: hva må være sant før drift (måling, monitorering, fallback, ansvar)? 5) Endringer: hva regnes som “substansiell endring”, og hvem godkjenner? 6) Hendelser: hvem tar lead ved feil, avvik eller uønskede utfall?

Tips: Bruk NIST AI RMF som språk for hva dere “må ha kontroll på” (Govern/Map/Measure/Manage).[2] Og hvis dere har høyrisiko som provider, map dette mot AI Act sitt kvalitetssystemkrav – så governance blir et system, ikke en “sjekk”.[3]

6. Minimumsartefakter som gir fart (ikke byråkrati)

Dette er de fem tingene som faktisk øker tempoet fordi de fjerner diskusjoner senere:1) KI-register (inventar): hvilke KI-løsninger finnes, hvor brukes de, hvem eier dem, hvilken risiko? 2) “System card” (1–2 sider): formål, brukere, data, modell, begrensninger, overvåkning, kontaktpunkt. 3) Måleplan i drift: KPIer + guardrails + hvem følger opp (lenk til artikkelen deres om kontrollspor/måleplan). 4) Endringspolicy: hva krever ny vurdering/godkjenning ved oppdatering? 5) Personvernspor: når DPIA er nødvendig, og hvordan den gjennomføres i praksis.[8]

Dette harmonerer godt med prinsippene om ansvarlighet, transparens og menneskelig kontroll/tilsyn i internasjonale rammeverk som OECDs AI-prinsipper.[5]

7. RACI-malen du kan kopiere

| Aktivitet / beslutning | Accountable (A) | Responsible (R) | Consulted (C) | Informed (I) |

|---|---|---|---|---|

| Prioritere use-case | Porteføljeansvarlig | Produkteier | Prosesseier, dataeier, risiko | Ledergruppe |

| Godkjenne data til formål | Dataeier | Dataforvalter | Personvern, sikkerhet | Produkteier |

| Risiko-klassifisering (light/høyrisiko) | Risiko-/compliance-eier | Modeleier | Juss, personvern, prosess | KI-eier |

| Go-live | Produkteier | Modeleier | Risiko, sikkerhet, personvern | Linje |

| Effekt/gevinst i drift | Prosesseier (linje) | Gevinstansvarlig | Produkteier | Ledergruppe |

Merk: Prosjektveiviseren/DFØ peker på at gevinstansvarlig normalt bør være en leder i linjen som faktisk realiserer gevinstene – og at dette bør være tydelig tidlig i løpet.[7]

8. Begynn nå: slik etablerer dere modellen på 7 dager

Dag 1: Navngi roller (én person per rolle) for to konkrete KI-initiativ. Dag 2: Lag beslutningsmatrise for de seks beslutningene (hvem har A). Dag 3: Opprett KI-register (start i et enkelt regneark). Dag 4: Lag “system card” for ett initiativ (maks 2 sider). Dag 5: Definer go-live-krav (inkl. måleplan/monitorering og fallback). Dag 6: Avklar DPIA-trigger og ansvar (hvem initierer, hvem kvalitetssikrer). Dag 7: Kjør en 45-min “governance dry run”: simuler en endring og en hendelse – sjekk om modellen holder.9. Vanlige feil (og hva dere gjør i stedet)

Feil 1: “IT eier KI.” I stedet: Forretning eier effekt, IT eier plattform, risk/compliance eier kontroll – med tydelige beslutningsrettigheter.Feil 2: Governance = dokumenter i en mappe. I stedet: Governance = flyt: beslutninger, logging, monitorering, hendelser og endringer (koblet til drift).

Feil 3: Alle use-caser behandles likt. I stedet: Risikobasert “fast lane” for low-risk, strengere krav ved høyrisiko (og tilsvarende kompetanse/AI literacy hos de som bruker systemene).[9]

Feil 4: Ingen eier gevinstrealisering etter prosjektet. I stedet: Linje eier gevinst (DFØ/Prosjektveiviseren) – med en navngitt gevinstansvarlig tidlig.[6][7]

Referanser

- ISO (ISO/IEC 42001:2023): ISO/IEC 42001:2023 – AI management systems.

- NIST (oppdatert 2025-02-06): NIST AI RMF Playbook (Govern, Map, Measure, Manage).

- EU-kommisjonen (AI Act Service Desk): Article 17 – quality management system (high-risk AI).

- NIST (rammeverk): AI Risk Management Framework (oversikt).

- OECD (oppdatert 2024): OECD AI Principles.

- DFØ: Roller og ansvar i gevinstrealiseringsprosessen.

- Prosjektveiviseren (Digdir): Rollen “gevinstansvarlig”.

- Datatilsynet: Vurdering av personvernkonsekvenser (DPIA).

- EU-kommisjonen (FAQ): AI literacy – Q&A (bl.a. opplæring/kompetansekrav for brukere av høyrisiko).

- Microsoft: Responsible AI Principles and Approach (governance og rolleavklaring).