PÅ FARTEN? LYTT ELLER SE

Oppsummering

De fleste KI-systemer i HR som vurderer mennesker (rekruttering, oppsigelse, oppgavetildeling, overvåking) vil typisk være høyrisiko etter EU AI Act. GDPR gjelder fortsatt fullt, og arbeidsmiljøloven kap. 9 gjør prosess og medbestemmelse til en portvakt i Norge. Denne artikkelen gir deg rammeverket for å navigere trygt i skjæringspunktet mellom teknologisk innovasjon, juss og etikk.

Innledning: det digitale arbeidslivets nye grunnlov

Norske virksomheter går fra “passive” støttesystemer til algoritmisk ledelse – der KI påvirker beslutninger om mennesker:

rekruttering, vurdering av prestasjon, styring av arbeid, og i verste fall oppsigelse. Dette lover effektivitet, men reiser samtidig spørsmål om

personvern, autonomi, rettssikkerhet og maktbalanse.

I årene frem mot 2027 skjer en regulatorisk tilpasning der EU AI Act må forstås i samspill med GDPR og arbeidsmiljøloven.

Efterlevelse er ikke lenger una isolert IT- eller juridisk øvelse – det må bli en styringsdisiplin.

Det regulatoriske landskapet: en tredelt struktur

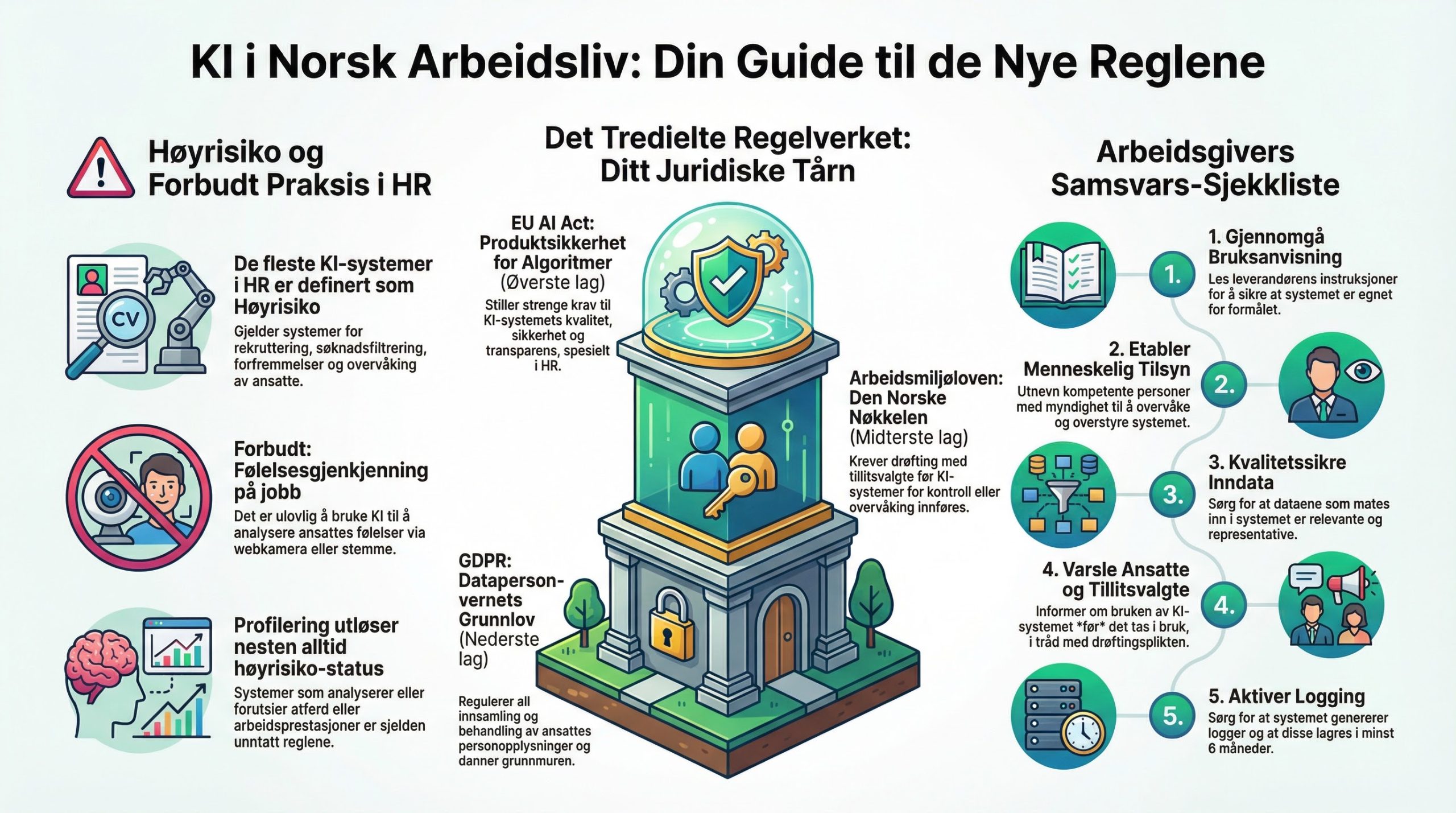

Illustrasjon: den tredelte strukturen

Du må lykkes i alle tre lag samtidig.

EU AI Act

Produktsikkerhet for algoritmer: risikoklassifisering, krav til kvalitet, dokumentasjon, transparens og menneskelig kontroll.

GDPR

Rettmessig behandling av personopplysninger: rettslig grunnlag, formålsbegrensning, dataminimering, rettigheter og vern mot helautomatiserte avgjørelser.

Arbeidsmiljøloven

Norsk prosess og medbestemmelse: saklig grunn, forholdsmessighet og drøfting av kontrolltiltak før iverksettelse.

Poenget er ikke at AI Act “erstatter” GDPR – den bygger videre på den, mens arbeidsmiljøloven ofte skjerper prosessen i norsk kontekst.

GDPR: grunnmuren i HR

I HR-kontekst utfordres særlig formålsbegrensning: data samlet inn for ett formål (f.eks. adgang/sikkerhet) brukes plutselig til å predikere fravær eller “burnout”.

I tillegg står retten mot helautomatiserte avgjørelser sentralt – i praksis kreves human-in-the-loop.

EU AI Act: risikobasert regelverk

AI Act innfører en risikobasert klassifisering og strenge krav til høyrisikosystemer – spesielt relevant fordi HR peker seg ut som et område med

iboende risiko for fundamentale rettigheter.

Arbeidsmiljøloven: særnøkkelen i Norge

Arbeidsmiljøloven kapittel 9 gjør at KI som kan overvåke/styre ansatte ofte blir et kontrolltiltak. Da kreves saklig grunn, forholdsmessighet,

og drøfting med tillitsvalgte før tiltaket iverksettes.

Høyrisiko KI-systemer i HR: hva som typisk omfattes

Kjernen i AI Acts relevans for HR ligger i vedlegg III (Annex III): use cases som typisk utløser høyrisiko-status. I praksis er “HR-unntak” snevert,

og profilering gjør at systemer svært ofte blir høyrisiko.

Typiske høyrisiko-områder i HR

- Rekruttering og utvelgelse: målrettet annonsering, CV-parsing/filtrering, kandidatvurdering (tester, video).

- Beslutninger i arbeidsforholdet: lønn, forfremmelse, endringer i vilkår.

- Oppsigelse/terminering: systemer som foreslår nedbemanning eller “predikerer” hvem som bør sies opp.

- Oppgavetildeling og overvåking: algoritmisk ledelse, produktivitetsmålinger, prestasjons- og atferdsovervåking.

Den snevre utveien: “narrow procedural task”

Noen systemer kan nedklassifiseres dersom de kun gjør en smal prosedyreoppgave. Men dersom systemet innebærer profilering av fysiske personer,

skal det regnes som høyrisiko – og i HR er profilering nærmest standard.

Forbudte praksiser: hva HR ikke kan gjøre

Enkelte KI-bruksområder er så inngripende at de er forbudt. For HR er særlig disse relevante:

- Følelsesgjenkjenning på arbeidsplassen: programvare som “måler engasjement/tretthet” via kamera, eller analyserer stemmeleie for å utlede emosjonell tilstand.

- Prediktiv politiering (overført til HR): integritetstester eller risikosystemer som forsøker å forutsi kriminalitet/underslag basert utelukkende på profilering/personlighetstrekk.

Dette er ikke “compliance-detaljer” – det er røde linjer som bør inn i innkjøpskrav og leverandørvurdering.

Arbeidsgiverens plikter som deployer

Som regel er arbeidsgiver bruker (deployer) av et HR-system levert av en provider. Likevel får arbeidsgiver et selvstendig og omfattende ansvar:

det holder ikke å “stole blindt på leverandøren”.

Menneskelig tilsyn (human oversight)

- Utpek konkrete personer med ansvar for å overvåke systemet (kompetanse, myndighet, støtte).

- Evne til å oppdage automation bias (tendensen til å stole for mye på maskinen).

- Evne til å tolke output korrekt, overstyre, reversere og stoppe systemet (kill switch).

- Bygg AI literacy i HR/ledelse (forstå statistikk, sannsynlighet og feilmarginer – uten å kunne kode).

Datastyring og inndatakontroll

Der arbeidsgiver påvirker input, må data være relevante og representative. Import av utenlandske systemer krever ekstra validering

(f.eks. norske karakterutskrifter, stedsnavn, karrieremønstre).

Loggføring og dokumentasjon

Sørg for at loggene lagres lenge nok til å kunne etterprøve beslutninger. Loggene blir bevismateriale ved spørsmål fra fagforeninger, ansatte eller søkere.

Transparens og informasjonsplikt

- Til tillitsvalgte: detaljert info om formål, teknologi og konsekvenser for arbeidsmiljøet.

- Til den enkelte: opplysning om at vedkommende er gjenstand for et KI-system, og kontekstuell forklaring av funksjon (ikke bare en generell personvernerklæring).

Illustrasjon: praktisk deployer-flyt

-

Kartlegg systemet (use case + dataflyt)

-

Risikovurder (DPIA + FRIA-prinsipper)

-

Etabler human oversight (roller, opplæring, overstyring)

-

Transparens (ansatte + tillitsvalgte) før oppstart

-

Drift: logging, bias-monitorering, rapportering

Bruk flyten som “standard operating procedure” for alle nye HR-KI-initiativer.

Det doble kravet: DPIA og FRIA – og den integrerte modellen

To konsekvensutredninger blir sentrale: DPIA etter GDPR og FRIA etter AI Act.

DPIA utløses ofte i arbeidslivet, særlig ved profilering og overvåking. FRIA har et bredere rettighetsfokus (menneskeverd, ytringsfrihet, ikke-diskriminering,

rettferdig prosess m.m.).

Hvem må gjøre FRIA?

FRIA-kravet gjelder særlig offentlige organer og private aktører som yter offentlige tjenester, samt enkelte brukstilfeller (f.eks. kreditt-/forsikringsvurdering).

Mange private virksomheter kan være formelt unntatt – men står fortsatt i praksis ansvarlig for å dokumentere rettferdighet, forholdsmessighet og ikke-diskriminering.

Anbefaling: én “AI impact assessment”

Etabler én felles prosess som slår sammen elementene fra DPIA og FRIA. Det sparer ressurser, gir helhet, og dokumenterer ansvarlighet overfor både tilsyn og ansatte.

Minimumsinnhold i en integrert vurdering

- Use case, beslutningspunkter og konsekvenser for den enkelte.

- Data: kilder, formål, dataminimering, lagring, tilgang og deling.

- Rettferdighet: bias-testing, representativitet, forklarbarhet og avvikshåndtering.

- Menneskelig kontroll: overstyring, eskalering, ansvarslinjer, opplæring.

- Arbeidsmiljø: belastning, overvåkingsgrad, endring i styring/maktbalanse.

Den norske modellen: drøfting, legitimitet og tillit

Arbeidsmiljøloven § 9-1 og § 9-2 gjør at KI-systemer som kan spore atferd, prestasjoner eller tidsbruk ofte må behandles som kontrolltiltak.

Det krever saklig grunn, ikke uforholdsmessig belastning – og forutgående drøfting med tillitsvalgte.

Hva tillitsvalgte skal ha reell innflytelse på

- valg av system

- hvilke data som samles inn

- hvordan dataene brukes og lagres

- hvordan systemet evalueres over tid

Dette er ikke “tungt byråkrati” – det er et konkurransefortrinn i Norge: legitimitet, høyere adopsjon, lavere konfliktnivå og bedre styringsinformasjon.

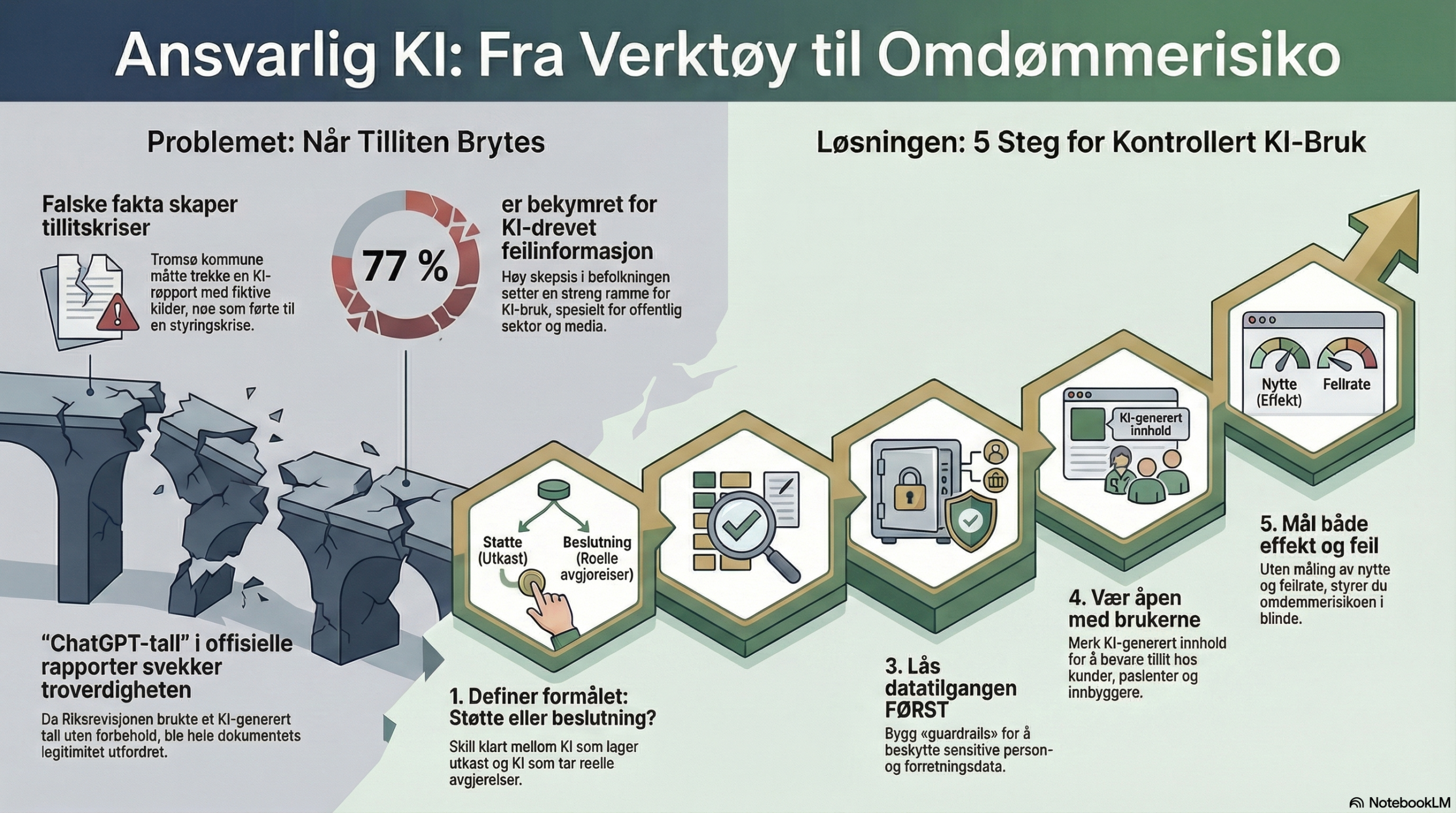

Tilsyn i Norge: Datatilsynet og Nkom

I den foreslåtte norske modellen får Nkom en rolle som markedstilsynsmyndighet for AI Act (produkttilsyn), mens Datatilsynet beholder tilsynsansvar for

personopplysninger (brukerstilsyn). For HR betyr dette to spor:

- Produkttilsyn (Nkom): er systemet lovlig, CE-merket og sikkert?

- Brukerstilsyn (Datatilsynet): bruker vi systemet lovlig, med rettslig grunnlag og personvern ivaretatt?

Veikart: implementering frem mot 2026–2027

Selv om krav trer inn gradvis, må forberedelser starte tidlig – særlig fordi bytte av sentrale HR-systemer tar tid og påvirker organisasjonen bredt.

| Fase | Mål | Aktiviteter |

|---|---|---|

| Fase 1 | ||

| Nå – Q4 2025 | Full oversikt over systemer med algoritmiske komponenter | Kartlegg HR/IT-portefølje, identifiser use cases (rekruttering, LMS, vaktplan, monitorering) og klassifiser etter vedlegg III |

| Fase 2 | ||

| Nå – Q2 2026 | Sikre leverandørcompliance | Krev samsvarserklæringer/CE, revider databehandleravtaler, be om dokumentasjon på treningsdata og bias-testing |

| Fase 3 | ||

| Q1 2026 – Q3 2026 | Etabler human oversight og rutiner | Opplæring (AI literacy), instrukser for tilsyn, gjennomfør integrert DPIA/FRIA, tett drøfting med tillitsvalgte/verneombud |

| Fase 4 | ||

| August 2026 → | Operativ drift i henhold til regelverk | Løpende logging, bias-monitorering, jevnlig rapportering til ledelse og tillitsvalgte |

Konklusjon: fra risiko til mulighet

AI Act og skjerpet GDPR-håndhevelse markerer slutten på “det ville vesten” i HR-tech. Det betyr økte krav og mer arbeid, men also en mulighet:

ved å validere nøyaktighet og rettferdighet kan virksomheter faktisk rekruttere bedre – og redusere historiske skjevheter.

Nøkkelen er å løfte KI-etterlevelse ut av IT og inn i styrerom og samarbeidsfora. I norsk arbeidsliv er tillit en strategisk valuta.

Anbefalte neste skritt

- Sett ned en tverrfaglig arbeidsgruppe (HR, IT, juridisk, tillitsvalgte).

- Start kartleggingen i dag (ikke vent til 2026 – bytte av kjernesystemer tar tid).

- Oppdater kompetansen (de som overvåker systemene må forstå hva de ser på).

- Formaliser prosessene (integrer KI-risikovurdering i HMS og internkontroll).

Merk: Rapportens vurderinger er basert på rettskildebildet per 2025, og norske lovforslag knyttet til gjennomføring av AI Act kan endre detaljer.