PÅ FARTEN? LYTT ELLER SE

Oppsummering

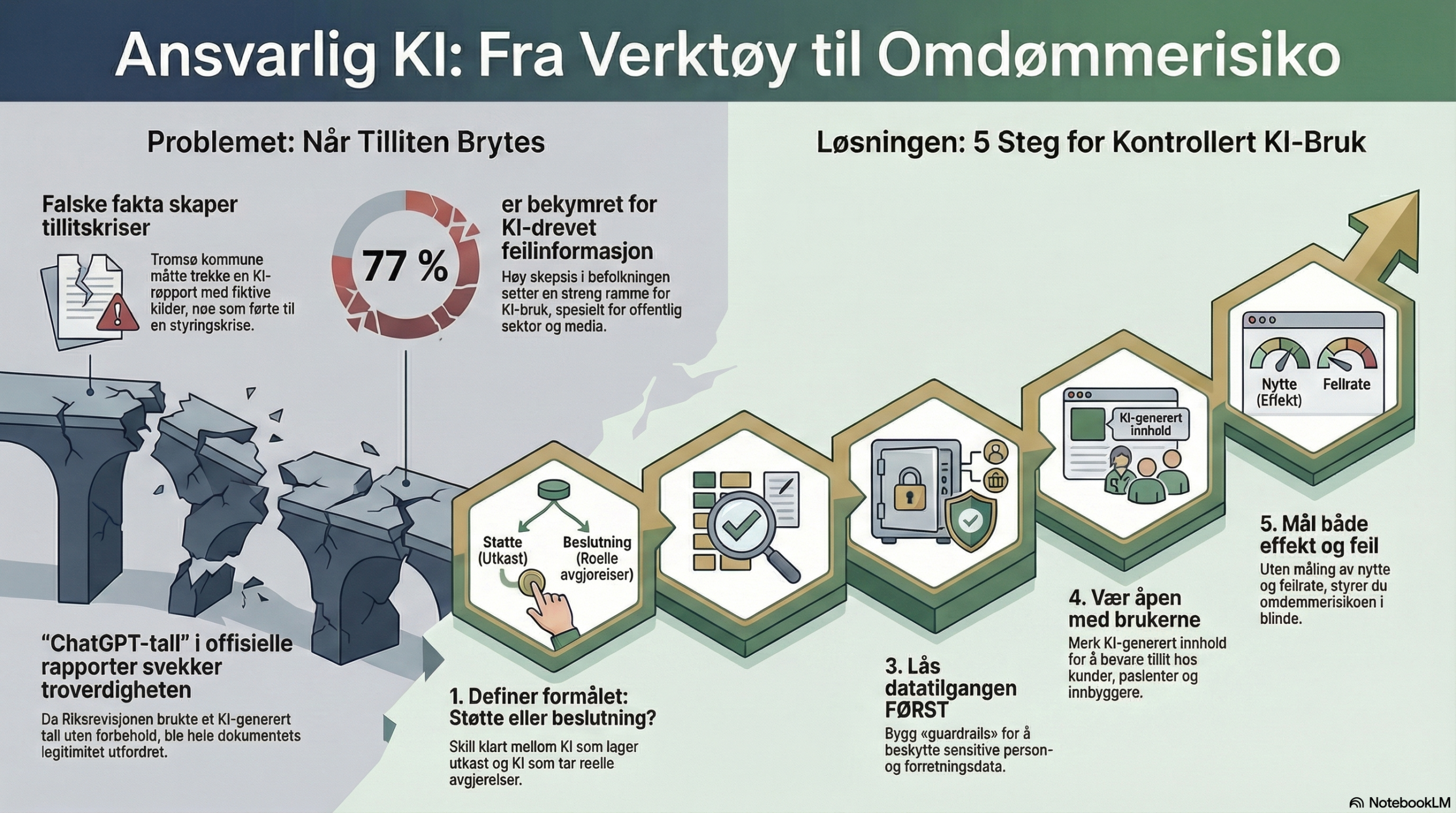

Kunstig intelligens har gått fra «smart verktøy» til omdømmerisiko på rekordtid. I Norge har flere høyt omtalte saker de siste 2–3 årene vist det samme mønsteret: Gevinstene kan være store, men når kvalitet, personvern eller åpenhet svikter, blir konsekvensen ofte sterk medieoppmerksomhet – og et tillitsproblem som tar lang tid å reparere.

Her ser vi på noen konkrete norske eksempler og viser hva som faktisk skjer når KI brukes – riktig og galt – og hvorfor «ansvarlig KI» nå er et forretningskritisk tema.

1. Hvorfor KI-bruk plutselig blir en omdømmesak

KI skaper oppmerksomhet av tre grunner:

- Hastighet og skala: Feil kan masseproduseres før noen rekker å oppdage dem.

- Utydelig ansvar: Når «systemet foreslo» noe, blir det fort uklart hvem som faktisk står inne for resultatet.

- Tillit er selve produktet i mange bransjer: Offentlig sektor, helse, finans og media lever på legitimitet. Når folk føler seg lurt, overvåket eller feilinformert, slår det direkte inn i omdømme – og i enkelte tilfeller i tilsyn, pålegg og politisk press.

Det viktigste poenget: KI-feil oppleves sjelden som “vanlige feil”. De oppleves ofte som brudd på integritet, profesjonalitet eller sannhet – og derfor blir reaksjonene kraftigere.

2. Case: Tromsø – da en KI-generert rapport utløste full krise

Hva skjedde: Tromsø kommune bestilte en rapport som senere ble trukket tilbake etter at den inneholdt fiktive eller feilaktige referanser. Saken vokste raskt fra “kvalitetsfeil” til en bredere tillits- og styringskrise. [1] [2]

Konsekvenser (kort fortalt):

- Offentlig tillit ble utfordret: Når en kommune legger frem underlag i en politisk betent sak (skole/struktur), forventer innbyggerne dokumenter som tåler offentlighetens lys.

- Ledelsesmessige konsekvenser: Saken førte til store interne ringvirkninger og ble behandlet som en alvorlig svikt i rutiner og kontroll. [2]

- Styringssignal til resten av Norge: Kommunen ble et nasjonalt eksempel på hvorfor KI må håndteres som risikostyring – ikke “kontortriks”.

Læringspunktet: Hvis KI brukes i beslutningsgrunnlag, må det være verifiserbart. “Ser akademisk ut” er ikke godt nok.

3. Case: Riksrevisjonen – når «ChatGPT-tall» havner i offisiell rapportering

Hva skjedde: Aftenposten omtalte kritikk av at et tall (om potensielle årsverk-effekter av KI) stammet fra ChatGPT/metodebruk – og at dette ble brukt uten tilstrekkelige forbehold i offentlig sammenheng. [3]

Konsekvenser:

- Debatt om metode og etterrettelighet: Når tall brukes i politikk og styring, må usikkerhet kommuniseres eksplisitt – ellers blir det en troverdighetssak.

- Risiko for “institusjonell mistillit”: Når folk oppfatter at KI genererer tallgrunnlag i stedet for analyse, svekkes respekten for hele dokumentet – også det som er solid.

Læringspunktet: KI kan støtte analyse – men kildegrunnlag, antakelser og usikkerhet må tåle revisjon.

4. Case: Fastlegekontoret – KI som lytter, skriver og utfordrer pasienttillit

Hva skjer i markedet: Norske løsninger som Noteless og andre journalassistenter har fått rask utbredelse, fordi de kan redusere dokumentasjonsbyrden betydelig. Dagens Medisin beskrev høy vekst og stor produksjon av KI-genererte journalnotater. [5]

Hvorfor dette får oppmerksomhet: I helse handler alt om tillit og sensitivitet. Aftenposten løftet nylig spørsmålet direkte: KI tar opp samtaler – hvor trygt er det egentlig? [4]

Konsekvenser (dobbel effekt):

- Positiv effekt: Tid spart, mindre stress, potensielt bedre struktur i notater (hvis brukt riktig). [5]

- Reell tillitsrisiko: Pasienter reagerer ulikt. Selv ved samtykke og gode rutiner kan opplevelsen av overvåkning eller “maskin i rommet” svekke åpenhet i konsultasjonen. [4]

- Behov for profesjonsstyrte rammer: Legeforeningen beskriver at flere løsninger ble presentert og diskutert – et signal om at feltet modnes, men at standarder og praksis fortsatt er i utvikling. [6]

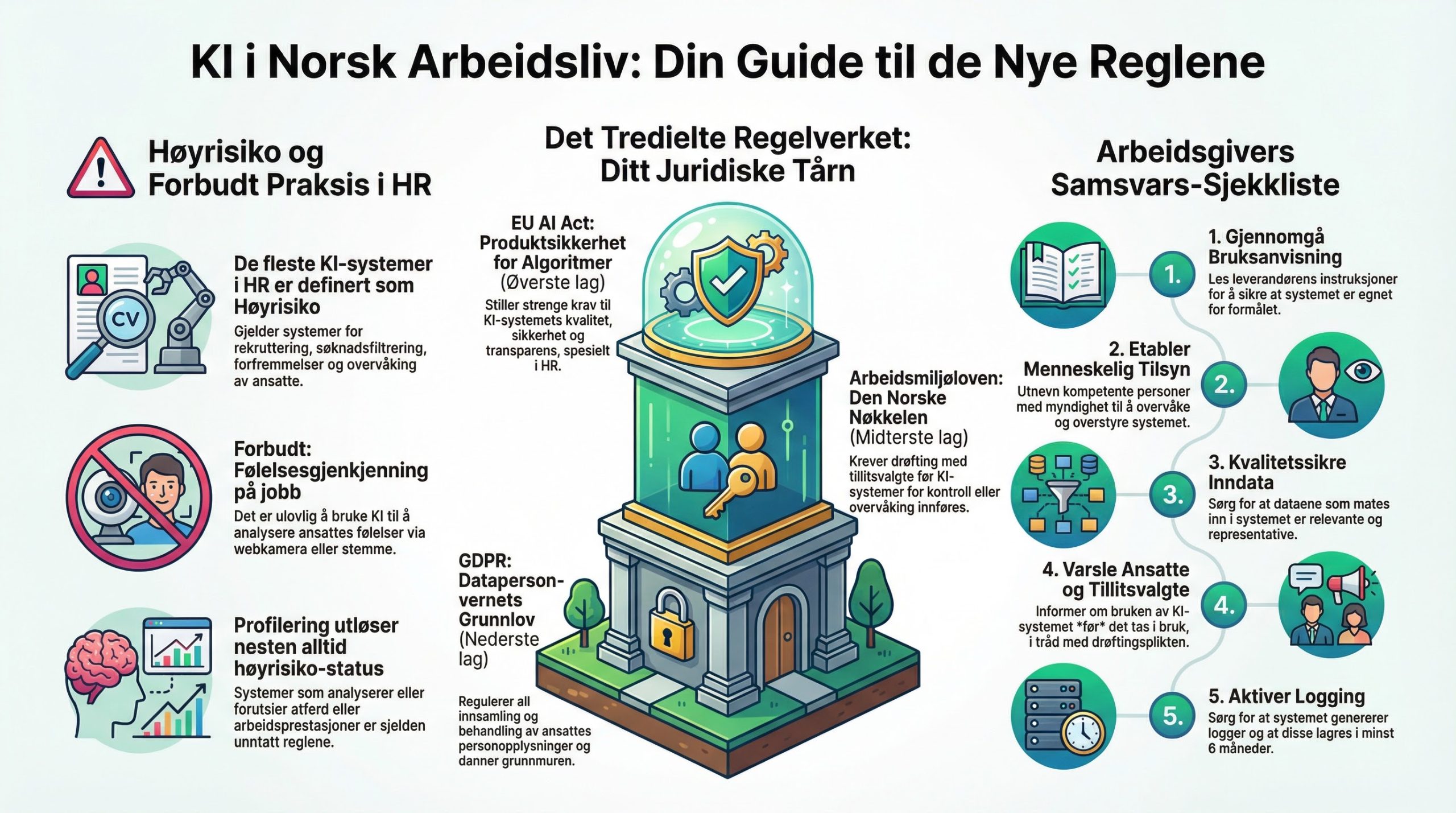

- Juridisk/etisk tyngde: Lovdata-artikkel peker på at KI i journalføring kan innebære høy personvernrisiko og må underlegges strenge krav til forsvarlighet (GDPR og helselovgivning). [7]

Læringspunktet: I helse er “ansvarlig KI” ikke en policy – det er pasientsikkerhet, personvern og relasjonell trygghet i praksis.

5. Case: Mediehus – «heiVG» og KI i front mot publikum

Hva skjedde: VG lanserte «heiVG» som en KI-assistent for nyheter – en av de tydeligste norske eksemplene på KI direkte mot publikum i stor skala. [8]

Konsekvenser:

- Høy verdi hvis det fungerer: Bedre navigasjon i nyhetsstrøm, raskere svar, lavere terskel for å forstå komplekse saker.

- Høy omdømmerisiko hvis det feiler: I media er feil ikke bare feil – de blir “desinformasjon”. Derfor må redaksjonelle prinsipper, kildekrav og tydelig merking sitte ekstremt stramt.

Læringspunktet: Når KI “snakker på vegne av” en redaksjon, blir det i praksis en del av publiseringskjeden – og må styres deretter.

6. Case: Forsikring – Gjensidiges «Eglev» og kontrollert GenAI i kjerneprosesser

Hva de gjorde: Gjensidige presenterte eksempler på hvordan de bruker generativ KI for å øke fart og effektivitet, blant annet gjennom en intern “AI analyst” (Eglev). Presentasjonen beskriver også guardrails (kontrollmekanismer) for å hindre tilgang til personlige og markedssensitive data. [9]

Konsekvenser (konkretisert):

- Produktivitet og kapasitet: Presentasjonen oppgir blant annet anslag knyttet til volum av dataeksportforespørsler og tidsbesparelse på håndtering. [9]

- Normalisering av “policy + rutiner” rundt GenAI: På et tidspunkt der mange virksomheter fortsatt “tester litt”, viser dette en mer industrialisert modell: bruksområde + datatilgang + sperrer + arbeidsflyt.

Læringspunktet: Denne typen caser er viktige fordi de viser en vei ut av “KI-kaos”: avgrenset tilgang, tydelige rutiner, målbare effekter.

7. Hvor redde er norske virksomheter for tap av tillit og omdømme?

Vi kan ikke måle “frykt” direkte hos alle virksomheter, men vi kan triangulere fra tre sterke signaler:

- Tillit til KI faller i nordiske organisasjoner: Deloitte rapporterer fall i høy tillit til GenAI (fra 53% til 40%) i nordiske organisasjoner, og knytter det til økt bevissthet om begrensninger/risiko og regulatorisk oppmerksomhet. [10]

- Befolkningen er tydelig bekymret for misinformasjon: KPMG-undersøkelse (2025) viser at 77% er bekymret for KI sin rolle i falske nyheter og feilinformasjon (og 60% for mer effektiv meningspåvirkning). Dette setter en direkte omdømmeramme rundt KI-bruk – særlig for media, offentlig sektor og merkevarer med høy tillitsavhengighet. [11]

- Offentlig sektor bruker KI, men sliter med gevinstrealisering: Digdir omtaler at over halvparten av offentlige virksomheter bruker KI, men at bare én av fire klarer å gjøre effektiviseringsgevinst om til reelle kostnadsbesparelser. Når gevinster er uklare, tåler man mindre risiko før man “mister troen” – internt og eksternt. [12]

Tolkning: Norske virksomheter er i økende grad rasjonelt forsiktige. Ikke fordi de hater KI, men fordi de ser at én uheldig sak kan bli en nasjonal nyhet, et tilsynstema eller et varig tillitsproblem.

8. Hva ansvarlig KI betyr i praksis

Her er en praktisk “minste levedyktige” standard for ansvarlig KI – laget for ledere som vil ha fart og kontroll:

- 1) Definer hva KI får lov til å påvirke: Skille mellom “støtte” (utkast, sortering, oppsummering) og “beslutning” (prioritering, avslag, tildeling, diagnose, publisering).

- 2) Innfør dokumentert kilde- og verifiseringskrav der feil er dyrt: Hvis output kan havne i politikk, pasientjournal, kundebrev eller presse: verifiserbarhet er et krav, ikke et håp.

- 3) Lås datatilgang før du skrur opp ambisjon: Minimer data, segmenter tilgang, logg bruken, og bygg sperrer (“guardrails”) – særlig i helse/finans. [9]

- 4) Merk og informer brukere der det betyr noe: Hvis kunder/pasienter påvirkes, må de forstå hva som skjer – ellers taper du tillit selv om du følger loven.

- 5) Mål effekt og avvik: Hvis dere ikke kan måle nytte og feilrate, bygger dere omdømmerisiko på magefølelse.

Kilder

- Tromsø kommune: Ekstern vurdering av Tromsø-rapporten om skolestruktur.

- SKUP: Vedlegg: «Tromsøundersøkelsen» (metoderapport/vedlegg).

- Aftenposten: Riksrevisjonen hevdet at KI kunne spare 155.000 årsverk i staten. Men tallet stammet fra ChatGPT.

- Aftenposten: KI tar opp alt jeg forteller til fastlegen min. Hvor trygt er egentlig det?

- Dagens Medisin: Fastlegen sparer to timer hver arbeidsdag med kunstig intelligens.

- Legeforeningen: Kunstig intelligens i allmennlegetjenesten.

- Lovdata (Lov & Data): Forsvarlig bruk av kunstig intelligens i pasientjournaler – løfter og hallusinasjoner.

- VG: heiVG.

- Gjensidige: Analyst Day (2024) – eksempler på generativ KI og «Eglev».

- Deloitte: State of GenAI Nordics – utvikling i tillit.

- KPMG: AI-undersøkelsen 2025 – funn om bekymringer og tillit.

- Digdir: IT i praksis 2025: Fem av ti offentlige virksomheter bruker KI, men uteblir gevinstene?